‘대형언어모델(LLM)’에 이어 앞으로는 ‘대형멀티모달모델(LMM)’이라는 용어가 보편화될 것으로 보인다. 기존에는 ‘멀티모달 LLM’으로 불렀으나, 최근 미국의 일부 기업과 매체가 기존 모델과의 차별화를 위해 LMM이라는 새 용어를 밀고 있다.

이는 오픈AI의 ‘GPT-4V(비전)’에 이어 올말 출시 예정인 구글의 차세대 모델 ‘제미니’ 역시 LMM이며, 최근에는 오픈 소스 LMM ‘라바(LLaVA) 1.5’까지 개발자 사이에서 인기를 누리고 있기 때문이다.

이처럼 기존의 ‘언어’ 학습을 뛰어넘어 ‘이미지’ 학습까지 더한 LMM이 화두로 떠오르고 있다. 벤처비트는 11일(현지시간) 오픈 소스 커뮤니티에서 라바 1.5가 GPT-4V의 대안으로 떠오르며 인기를 얻고 있다고 소개했다.

LMM은 이미지를 학습했기 때문에 사용자가 텍스트 대신 이미지를 입력해도 이를 이해하고 답을 낼 수 있다. 이미지 입력 기능은 기존 언어모델의 활용폭을 크게 넓혀줄 수 있다.

이 기능은 지난 3월 오픈AI가 출시한 GPT-4부터 상용화됐다. 오픈AI는 이미 지난해 GPT-4의 이미지 학습을 마친 것으로 알려졌다.

이후 이미지 입력은 AI 모델 개발의 표준이 됐다. 빅테크는 물론 오픈 소스 커뮤니티까지 LMM 개발에 매달렸다. 최근 메타가 발표한 ‘메타 AI’도 멀티모달 기능을 갖췄다. 라바도 1.5 버전이 나올 정도로 업데이트를 거듭했다.

LMM이라는 용어가 부각된 것은 사실 제미니의 탓이 크다. 구글은 다른 모델과의 차별점으로 방대한 이미지와 동영상을 학습한 점을 강조했기 때문이다.

이에 따라 오픈AI는 지난달 25일 공식 블로그를 통해 ‘GPT-4V(ision) 시스템 카드’라는 논문을 소개했다. LLM에 이미지 입력을 통합한 기술적인 문제와 이를 통해 확보한 안전성 등에 초점을 맞춘 내용이다. 즉 LMM를 주도하는 게 오픈AI라는 것을 강조하는 내용이다.

여기에 오픈 소스 진영의 LMM 대표 주자로 라바 1.5가 떠오르며 본격적인 경쟁이 벌어지는 모양새다.

라바 1.5는 여러 생성 AI 구성 요소를 결합하고 높은 정확도로 다양한 작업을 수행하는 모델을 생성하도록 미세 조정됐다. LMM은 일반적으로 ▲이미지를 텍스트로 변환하는 비전 인코더 ▲LLM ▲비전 인코더와 LLM을 연결하는 ‘비전 언어 교차 모달 커넥터(vision-language cross-modal connector)’ 등 아키텍처를 활용한다.

이를 통해 2단계 프로세스를 거쳐 LMM을 훈련한다. 첫 단계인 비전-언어 정렬 사전 훈련은 이미지-텍스트 쌍을 사용해 시각적 특징을 언어 모델의 단어 임베딩 공간에 정렬한다. 이어 시각적 지침 조정을 통해 모델이 시각적 프롬프트에 따라 응답하도록 한다. 특히 두번째 단계는 컴퓨팅 집약적인 특성과 선별한 대규모 데이터셋이 필요하기 때문에 어려운 작업이라는 설명이다.

라바 1.5 역시 이 과정을 거쳤다. 비전 인코더로는 오픈AI가 2021년 개발해 ‘달리 2’에도 활용한 ‘클립(CLIP)’ 모델을 사용했고, 기본 언어모델로는 메타의 ‘라마’를 기반으로 하는 오픈 소스 sLLM ‘비쿠나(Vicuna)’를 활용했다. 이를 통해 LLM이 이미지를 기반으로 대화 및 추론 문제를 생성하도록 유도, 챗GPT를 통해 라바를 학습하기 위한 15만8000개의 훈련 예제를 효과적으로 생성해 냈다.

이후 언어 모델과 비전 인코더를 연결하고 데이터셋을 추가, 60만개에 달하는 데이터셋으로 라바 1.5의 학습을 진행했다. 특히 학습 과정은 8개의 A100 GPU를 활용, 비용이 하루 만에 몇백달러 수준에 그쳤다.

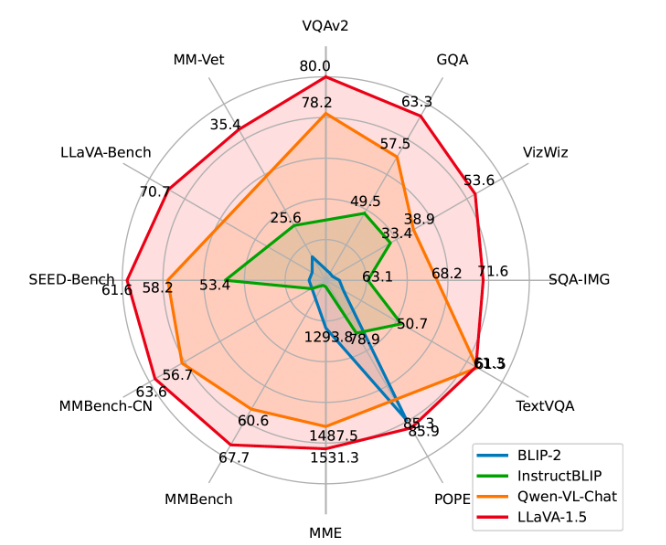

이렇게 탄생한 라바 1.5는 벤치마크 테스트 결과 다른 오픈 소스 LMM 11개의 성능을 뛰어 넘었다. GPT-4V의 오픈 소스 대항마로 꼽히는 것도 이 때문이다.

물론 단점도 있다. 챗GPT 생성 데이터를 학습했기 때문에 챗GPT의 사용 약관으로 인해 상업적 목적으로 사용할 수 없다. 또 개발 과정과 사용 편리성을 감안하면 GPT-4V와 비교하는 것 자체가 무리다.

그러나 “뛰어난 가성비와 오픈 소스 특성상 많은 개발자들의 손을 거치며 업그레이드할 수 있다는 점을 감안하면 충분히 잠재력이 있다”는 분석이다.

한편 라바 1.5는 현재 깃허브에 공개됐다. 개발에는 위스콘신-매디슨대학교와 마이크로소프트 리서치, 컬럼비아대학교 연구진이 참가했다.

임대준 기자 ydj@aitimes.com

morning music